Künstliche Intelligenz (KI) erlebt aktuell einen neuen Hype. Die Entwicklung künstlicher Intelligenz begann früh, schon 1956 fand das „Summer Research Project on Artificial Intelligence“ in Hanover (New Hampshire) statt. Mehrere KI-Pioniere trafen sich, um darüber zu diskutieren, wie man Intelligenz außerhalb des menschlichen Gehirns schaffen könnte.[1] Es folgten sogenannte KI-Winter, Phasen wo die KI Forschung und Entwicklung zurückging, weil die Grundlagen, nämlich nötige Rechenleistung und Speicherkapazität, sehr teuer waren. Jetzt sind sie günstig genug. KI hat in vielen Bereichen des alltäglichen Lebens bereits Einzug gehalten. KI hat schon und wird noch viel mehr unsere Arbeits- und Umwelt verändern. (Wirtschafts-)Psychologen werden mit den Folgen der Veränderungen, z.B. in der Mitarbeiterbetreuung, immer häufiger in Berührung kommen. Und sie müssen künstliche Intelligenz und ihr Verhalten verstehen lernen.

Die Art, wie KI lernt, ist von der Natur abgeschaut. In diesem Blog Beitrag werden in einem Überblick die natürlichen Vorlagen für maschinelles Lernen und das sogenannte Deep Learning betrachtet – biologische neuronale Netze und grundlegende Überlegungen, wie Lernen funktioniert. In einem weiteren Blog Beitrag („(Künstliche) Intelligenz – Basics“) wird näher auf KI und maschinelles Lernen eingegangen.

Biologische neuronale Netze

Unser Nervensystem besteht aus Nervenzellen bzw. Neuronen. Eine einzelne Nervenzelle kann noch keine Aufgaben bewältigen oder Reaktionen auslösen, vielmehr müssen die Nervenzellen in Strukturen gemeinsam arbeiten, um ein Ergebnis zu erzielen. In unserem Nervensystem sind die einzelnen Neuronen in hochkomplexen Prozessen organisiert. Je höher die Komplexität, desto höher ist die Fähigkeit zur Informationsverarbeitung.[2] Um also z.B. Essen zu erkennen und dieses dann zu verspeisen, bedarf es einem hochkomplexen Zusammenspiel von Nervenzellen in kleinster Zeit.

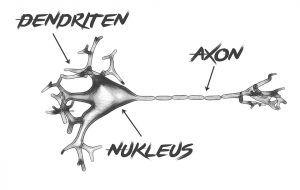

Nervenzellen haben zwei Zustände, das Ruhepotential und das Aktionspotential. Sie haben einen Zellkörper (Soma), in dem Energie erzeugt wird, Dendriten, über die die Nervenzelle Eingangssignale von anderen Nervenzellen erhält, und ein Axon, das sich stark verzweigt und somit viele Verbindungen zu anderen Nervenzellen aufbauen kann. Über das Axon werden die Ausgangssignale zu anderen Neuronen gesendet.[3]

Abbildung 1: Nervenzelle

Das menschliche Gehirn besteht aus ca. 1012 Nervenzellen und jede Zelle hat mit ca. 10000 bis 20000 anderen Neuronen Verbindungen, das ergibt ca. 1016 Kontakte.

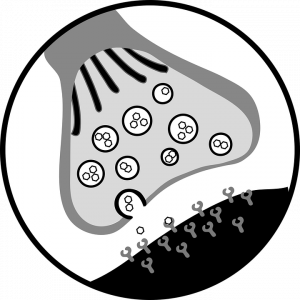

Abbildung 2: Synapse

Es sind keine direkten Verbindungen, sondern synaptische Verbindungen. In der Synapse werden ankommende elektrische Signale in chemische Signale umgewandelt. Es bedarf einem bestimmten Schwellwert, der überschritten werden muss, damit die Nervenzelle den Reiz weitergibt.[4] Die Eingangssignale können auch hemmende Wirkung auf das Neuron haben, setzen also das Aktionspotential herab.

Hebbsche Lernregel

1949 postulierte Donald O. Hebb eine Lernregel, die besagt, dass bei gemeinsamer Aktivität zweier Neuronen ihre Verbindung verstärkt wird. Die Verbindung verstärkt sich durch Langzeitpotenzierung, sie wird immer stärker bei gemeinsamer Aktivität, ist jedoch endlich. In der Synapse zwischen den beiden Nervenzellen wachsen die Rezeptoren und die Umwandlung von elektrischer Energie in chemische Prozesse wird immer schneller und effizienter. Die Lernregel dient als Basis zum Verständnis von Lernen und Gedächtnis.

Der Neuropsychologe K. Lashley vertrat die These, dass Informationen verteilt gespeichert wird, dass also das Gedächtnis nicht nur an einem Ort im Gehirn „sitzt“.[5]

Synaptische / Neuronale Plastizität

beschreibt die Möglichkeit, dass sich ein neuronales Netz anpassen kann. Je nach Umwelt und Einfluss können sich Verbindungen verstärken, wir lernen, mit einem Umstand effizienter umzugehen, aber es können sich auch Verbindung abschwächen, wir verlernen oder vergessen. Das neuronale Netz kann die Stärke der Verbindungen nach Bedarf verändern.[6]

Fazit

Dieser Blog Beitrag soll die natürlichen, neurophysiologischen Vorlagen in Grundzügen beschreiben, die zum Verständnis der Arbeitsweise von künstlicher Intelligenz und ihre Art zu lernen, beitragen.

Fußnoten

[1] vgl. Buxmann P., Schmidt H.(Hrsg.): S.4

[2] vgl. Zimbardo P., Gerrig R.: S.86

[3] vgl. Rösler F.: S. 17ff.

[4] vgl. Rösler F.: S. 17ff.

[5] vgl. Rösler F.: S. 31 und S. 171ff.

[6] vgl. Beck H., Anastasiadou S., Meyer zu Reckendorf C.: S.111

Abbildungen

Titelbild: https://pixabay.com/de/illustrations/k%C3%BCnstliches-neuronales-netz-anna-3501528/

Abbildung 1 Nervenzelle: https://pixabay.com/de/illustrations/nervenzelle-biologie-dendriten-axon-3509363/

Abbildung 2 Synapse: https://pixabay.com/de/vectors/kopf-wasser-chemische-diagramm-38071/

Literaturverzeichnis

Buxmann P., Schmidt H.(Hrsg.): Künstliche Intelligenz, Springer-Verlag GmbH Deutschland, 2019.

Beck H., Anastasiadou S., Meyer zu Reckendorf C.: Faszinierendes Gehirn, Springer-Verlag Deutschland GmbH 2016, 2018.

Rösler F.: Psychophysiologie der Kognition, Spektrum Akademischer Verlag Heidelberg, 2011.

Zimbardo P., Gerrig R.: Psychologie, 7. Auflage, Springer-Verlag, Berlin, Heidelberg, 1999.